当 OpenAI Sora 一夜搅得 AI 视频生成界天翻地覆,Runway 等老牌 AI 视频生成巨头反倒有些「销声匿迹」。

昨天深夜,Runway 放出酝酿了半年的全新版本 Gen-3 Alpha,也让我们再次见证了这些巨头的底蕴。

Runway Gen-3 Alpha 特点如下:

高保真视频生成:能够生成接近真实世界质量的视频内容,具有高度的细节和清晰度。

精细动作控制:模型能够精确控制视频中对象的动作和过渡,实现复杂场景的流畅动画。

逼真人物生成:特别擅长生成具有自然动作、表情和情感的逼真人类角色。

多模态输入:支持文字转视频、图像转视频、文字转图像等多种创作方式。

先进工具:支持运动画笔、相机控制和导演模式等专业创作工具。

增强的安全措施:引入新的内部视觉审核系统和 C2PA 标准,确保内容的安全性和可靠性。

高质量训练:使用高描述性的、时间密集的字幕进行训练,使模型能够理解和生成具有丰富时间动态的视频。

Gen-3 Alpha 更懂物理世界,更少 Bug 了

不看广告,看疗效,先来感受一下全新版本带来的视觉冲击。

Prompt: Subtle reflections of a woman on the window of a train moving at hyper-speed in a Japanese city.

一位女士的身影在日本城市中疾驰的火车窗上轻轻映现。她的轮廓在灯光的映照下显得格外柔和。目光似乎穿透了玻璃,凝视着外面那个快速后退的世界。

<iframe src="data:;base64, " frameborder="no" scrolling="no" allowfullscreen="allowfullscreen"></iframe>

Prompt: An astronaut running through an alley in Rio de Janeiro.

一条狭窄的小巷里,突然闯入了一位身穿太空服宇航员,奔跑在热情奔放的里约热内卢小巷中。

Prompt: A middle-aged sad bald man becomes happy as a wig of curly hair and sunglasses fall suddenly on his head.

画面中,一个中年男人头顶光滑如镜,脸上带着一丝忧郁。突然,一顶卷曲的假发和一副太阳镜从天而降,完美地落在他的头上。

瞬间,他的表情从悲伤转为惊喜,然后是无比的快乐。

Prompt: Handheld camera moving fast, flashlight light, in a white old wall in a old alley at night a black graffiti that spells 'Runway'.

一条陈旧的小巷里,手持摄像机的人快速穿梭,闪光灯划破黑暗,照亮了一面白色的旧墙。墙上拼写出的「Runway」黑色涂鸦格外显眼。

Prompt: FPV moving through a forest to an abandoned house to ocean waves.

镜头以第一人称视角,带领我们穿越茂密的森林,阳光透过树叶的缝隙,洒下斑驳的光影。

经过一座被岁月遗忘的荒废小屋,然后继续前行,直到视野突然开阔,一片波涛汹涌的大海展现在眼前,颇有几分「柳暗花明」的那股意味。

Runway 承诺上述所有视频均使用 Gen-3 Alpha 生成,未进行任何修改。

从官方分享的视频来看, 这些演示视频在质量上有了显著的提升,无论是对 AI 视频生成难以把控的夜景灯光,还是景别的流畅切换,Gen-3 Alpha 都称得上尽善尽美。

甚至在文字生成上也看得出来有下足了一番功夫。

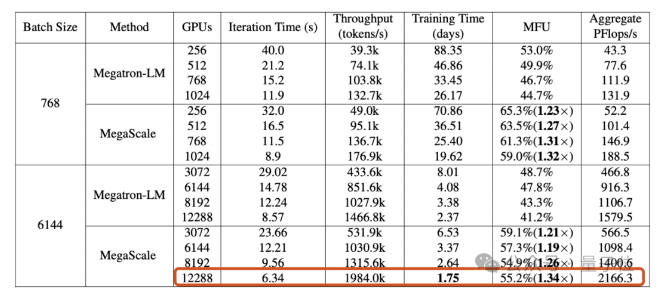

更重要的是,据 @iamneubert 透露,Gen-3 Alpha 模型的生成速度非常之快。官方分享的演示视频普遍徘徊在 10 秒水平线上,而这 10 秒视频只需要 90 秒的时间就能快速生成。

看完 Runway 分享的视频后,艺术家 @WorldEverett 都忍不住感慨,这看起来太惊艳了!顺带还给 OpenAI 上了一波强度。

不过也有网友质疑,虽然这个模型看起来非常出色,但它是基于受版权保护的作品进行训练的吗?如果是的话,这些作品是否已经获得了授权?

另外,不用担心这个新版本只是一个光看不能用的「期货」,因为 Runway 官方表示,Gen-3 Alpha 将在未来几天内向所有人推出。

昨日的 AI 王者,今日的过客?

Gen-3 Alpha 是 Runway 即将发布的一系列新模型的先行军。

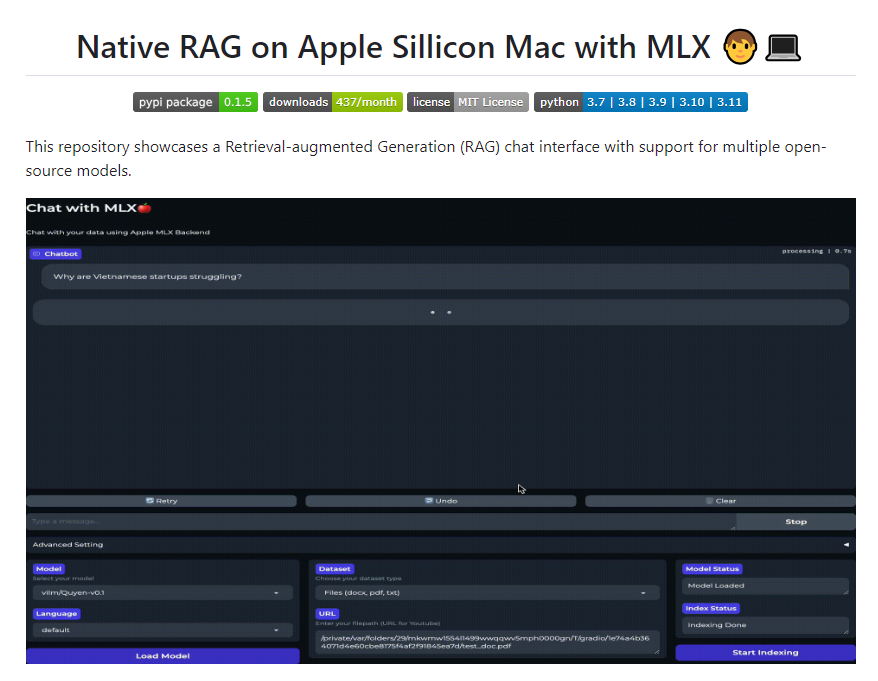

据官方介绍,这些模型是在专为大规模多模态训练量身定制的新基础设施上训练而成的。

相比于 Gen-2.它在逼真度、稳定性和动态表现上都有显著提升,并且朝着构建通用世界模型的方向迈进了一步。

经过视频和图像的双重洗礼,Gen-3 Alpha 将赋能 Runway 的文本转视频、图像转视频和文本转图像工具。

现有的控制模式,如运动画笔、高级摄像机控制、导演模式,以及即将推出的用于更精细调整结构、风格和动态的新工具的进化,让创作变得轻松可靠。

安全这一块儿,Gen-3 Alpha 也是全副武装。

它配备一系列新的安全保护措施,还包括全新升级的内部视觉审核系统和 C2PA 出处认证标准。

C2PA 是一项开放标准,旨在帮助用户识别数字文件(例如图像、录音或视频)的创建者或内容以及其编辑方式。

简单点说,就是给生成的视频打上「身份证」。

Gen-3 Alpha 通过高度详细且时间信息丰富的字幕进行训练,这种高质量的训练使得它能够创造出富有创意的过渡效果,甚至对场景中的元素进行精准的关键帧定位。

在生成富有表现力的人类角色上,Gen-3 Alpha 也是一把好手。

生成的角色能够展现多样的动作、手势和情感,为解锁全新的叙事打开新天地。就拿上方的演示视频来看,生成的「人类」也比 Gen-2 多了些人味。

据介绍,和 OpenAI Sora 一样,Gen-3 Alpha 的训练汇聚了研究科学家、工程师和艺术家的跨学科合作。

这样的好处是能够让其理解和运用多样的风格和电影术语,从而丰富 Gen-3 Alpha 的创作表现。

作为 Gen-3 系列模型的一部分,Runway 宣布正在与一些娱乐和媒体机构携手合作,打造符合特定需求的 Gen-3 定制版本。

这也是本次版本更新最值得关注的变化。

此前,Runway 曾为斩获奥斯卡金像奖的科幻电影《瞬息全宇宙》提供过技术支持,不过,当时运用的仅仅只是 Gen-2 版本。

而 Gen-3 Alpha 模型的定制化能够实现更精准的风格控制和角色一致性,满足特定的艺术和叙事需求,也将进一步加速 Runway 与影视行业的合作落地。

巧合的是,在同一天,「竞品」Luma AI 宣布 Dream Machine 即将带来更强大的编辑功能和更直观的操作体验,这种「不期而遇」不免有点打擂台的火药味。

附上内测申请地址: https://docs.google.com/forms/d/e/1FAIpQLScgsh3Cf2VXf8k7k9iVd-nP5NZk-TSRfq4Tkvh7inv8kS9Ulg/viewform?usp=send\_form

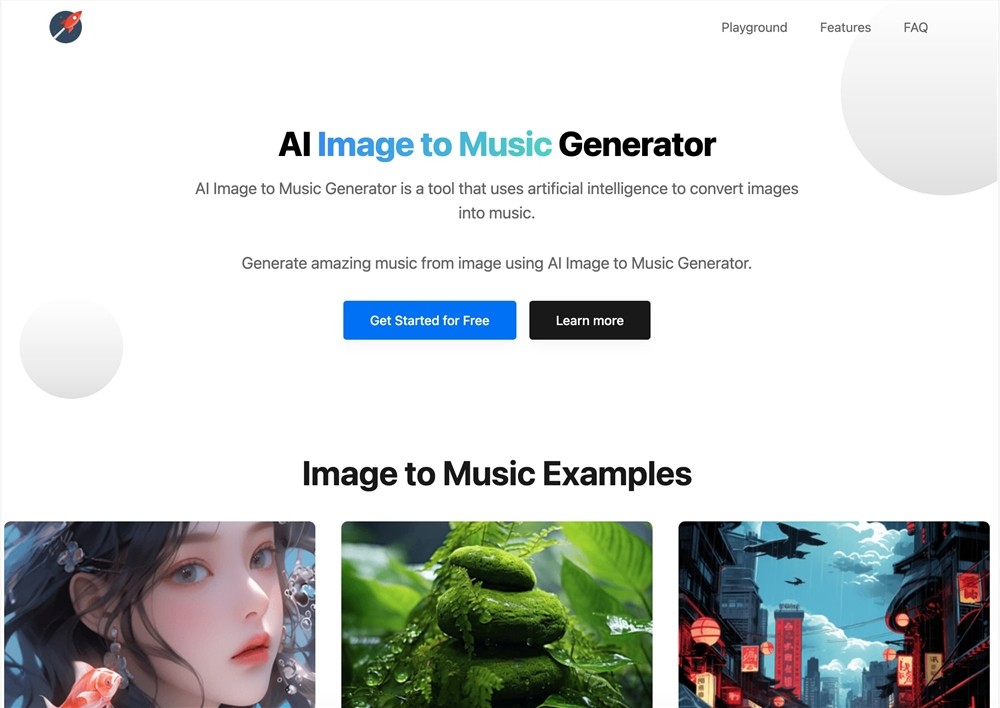

并且,Google 也不甘示弱,在社交平台 X 上宣布推出新的模型技术 Video-to-audio。

和 ElevenLabs 推出的 AI 音效生成功能有异曲同工之妙, Video-to-audio 支持根据视频和文本提示词生成和视频匹配的音频,甚至可以与主体角色唇形同步。

都说 2024 年是 AI 视频生成的元年,如今看来,这一变化也让人眼前一亮。

短短半年间,OpenAI Sora 给我们的震撼还没消化完,类 Sora 模型就在行业的内卷中如雨后春笋般涌现。

其中快手可灵、Dream Machine 的进步更是可喜的。

虽说一夜之间不至于让人类一败涂地,却也让整个内容行业往前进了一大步。

Gen-3 Alpha 此次放出的视频时长尽管只有短短十秒,但质量肉眼可见地上了一个大台阶,通俗点说,就是更「懂」物理世界了,更少「Bug」了。

都说全面对标是为了更好的超越,几乎每一个新模型新版本的窜头,都会给 Sora 狠狠地造成一波压力。

此前有消息称「期货」Sora 有望在年底前向公众开放,也希望其水准对得起埋了大半年的伏笔。

这或许也是 AI 视频生成发展仍处于初级阶段的重要表征,没有永远的 AI 视频生成王者,但每天都有新的王者诞生。

就像赫拉克利特说的的那样,世界是不断变化的,唯一不变的是变化本身。

本文摘自appso公众号