以下文章节选自丨腾讯科技

Kimi最近太火了…

2024年第一个真正走红的国产大模型。互联网上,随处可见Kimi打出的广告贴。

这是AI浪潮中,国内创业公司第一次真正“破圈”,在此之前都是互联网大厂的独舞。

最明显的标志是,在二级市场中,Kimi已被市场作为一个概念板块来对待,它们被称之为「Kimi概念股」,但凡名字带有“Kimi”都会因此“获益”。

除了资本市场的关注,实际的用户量也在飙升。

「AI产品榜(aicpb.com)」统计的数据显示,Kimi智能助手在2024年2月的月活访问量达305万,较今年1月环比成倍增长。

而根据第三方机构的不完全统计显示,目前国内已经发布的大型语言模型数量已经超过了300个。

在内卷如此竞争激烈的环境中,成立仅仅一年多的Kimi Chat母公司“月之暗面”为何引起如此高的关注?

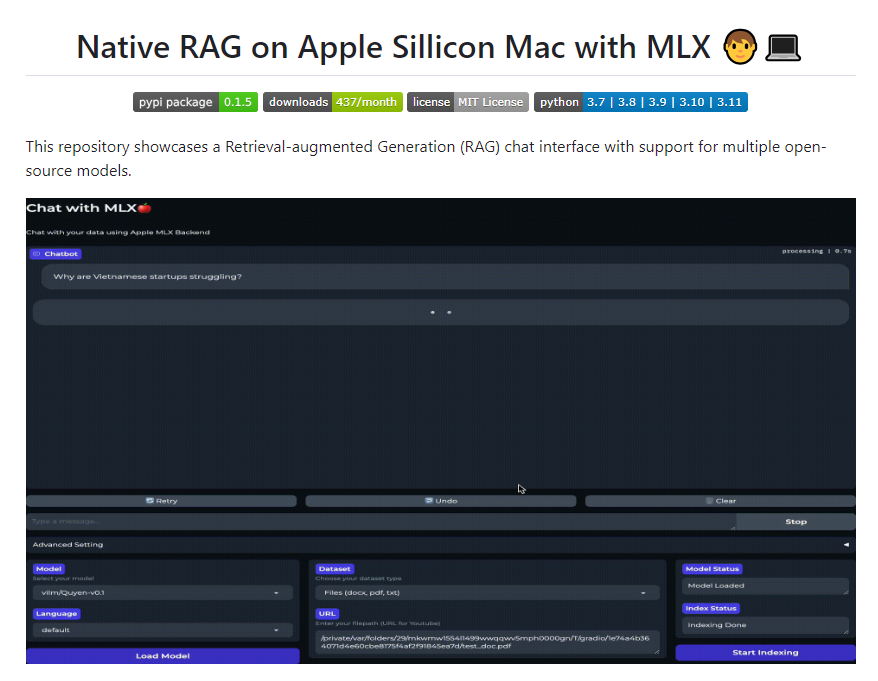

燃爆点始于3月18日,“月之暗面”宣布在大模型长上下文窗口技术上取得新的突破,其自研的Kimi智能助手已支持200万字超长无损上下文。

Kimi可以一次性“读完”“读懂”《三体》全部三部曲。你可以随性地将任意一个网页贴给Kimi,请他帮你解读。

这种Tokens能力在全球知名大模型中的水平如何?

看下图,国外长文本能力最强的谷歌Gemini 1.5、Claude 3支持100万tokens,Kimi具备200万汉字上下文Tokens长度,理论上或已超越海外顶尖大模型水平。

但是,大模型其中一项能力“遥遥领先”,似乎并不足以吸引所有的注意力,毕竟几乎所有大模型在发布的时候,都会交出一个优秀的基准测试成绩单,几乎所有的大模型,都是书面成绩上的「优等生」。

大模型的痛点:同质化严重

所以,在这样“卷”的大模型市场,Kimi究竟为什么会火?

其实它的火爆,也从侧面反应了大模型市场的痛点。过去一年,我们见过太多大模型的发布,每次标准动作有以下几个:

1、公布大模型的参数量XX亿

2、公布模型是开源,还是闭源

3、公布测试集的成绩(这些测试集被用于评估大模型在不同领域的能力,包括语言理解、知识问答、文本创作等

4、业内的测评文章大量释出

一番标准动作之后,对于普通的小白用户,面对一些晦涩难懂的技术参数,是很难对某个大模型产生太多的深刻记忆点。

Kimi是一家懂营销的大模型公司

相较于其他大模型开发商,Kimi选择了一个更有辨识度的方式亮相。

2023年10月10日,“月之暗面”宣布Kimi正式上线,通稿的标题中别有心裁地用了「欢迎与Moonshot AI共同开启Looooooooooong大语言模型时代」。

10个O组成的Long单词,让人一眼记住了Kimi的长文本吞吐能力。

“月之暗面”是懂互联网营销的,直接占领用户心智。从此,当用户看见“长文本”三个字就能想到“月之暗面”。

这就好比当用户看到“华为”就能想到“遥遥领先”。

与其他竞品不太一样的是,“月之暗面”的用户群体锁定在C端,支持更长的上下文”意味着大模型拥有更大的“内存”。

这个世界已经被PC、手机教育过了,每个普通人都有一个简单粗暴”的认知——“内存大”就意味着这款手机或电脑配置更高、性能更牛。

一波漂亮的宣传,Kimi在“卷评测分数”的大模型界轻松地赢得了普通用户的心。

“月之暗面”创始人杨植麟曾经在采访中强调:“长文本是大模型登月第一步。它很本质,它是AI新时代的「计算机内存」。”

占领用户心智意味着在目标消费者心中为品牌或产品创造一个独特而鲜明的符号画像。当消费者考虑购买某一类产品或服务时,你的品牌就很有希望成为首选。

当用户认为在国内的国产大模型里边,「长文本=Kimi」时就赢在了起跑线上。即使“后知后觉”的百度、阿里等大厂也宣布开放长文本能力,也没有影响到Kimi的热度。

长文本Tokens为何如此重要?

如果你把大模型当成一个虚拟数字人,Tokens的长度,决定了他具备的是“短期记忆”还是“长期记忆”。

长文本能力较短的大模型,超过其上下文承载能力的部分,大模型就会忘掉。

GPT3.5-Turbo初版上下文窗口长度仅有4K token,也就是大概2000字,超过两千字的对话内容它就基本记不住了。

想让ChatGPT分析更复杂文字更多的文档就更不可能了。可以说,Tokens制约了大语言模型完成真正复杂、多步的操作,也无法处理复杂的论文文档。

为了让大模型能够做更多事,拓展上下文就成了各路大模型争相竞逐的一个重要指标。

“月之暗面”的故事并不新鲜。

事实上,OpenAI的竞敌Claude大模型的杀手锏就是长文本,其初代模型就支持100k Token的上下文,直接可以处理5万字,使得它总能保有一群固定追随者。

目前使用大模型的大多数人群,还都是泛科技行业,有尝鲜能力的从业者、科技爱好者以及相关研究专业的学生,长文本处理能力毫无疑问是论文、深度研报、会议摘要这些有明确应用场景的刚需能力。

“月之暗面”的登月第一步,从用户需求场景出发,肯定是迈对了。

但是,从技术角度来讲,Kimi能领先多久?

上下文长度真的能形成护城河吗?

进入2024年,这项技术本身已经很难说的上是护城河了。当下,已经有越来越多成熟的手段去处理上下文的问题。

上下文扩展的问题之所以这么难解决,主要原因还是Transformer这个大模型基础框架本身。

1)对文本长度记忆非常死板,超过训练集最大长度就无法处理。

2)“注意力机制”十分浪费资源,耗费算力。

3)不擅长处理远端信息。

这三大难题其实已经有非常多的手段去规避。学界把增加上下文的方法主要归类为“外推”(Extrapolation)和“内插”(Interpolation),一般都会并行使用。

“外推”负责解决训练外资料无法编码的问题,并保证长文本处理的能力;此外,我们还需要让语言模型能够更好地理解它已经学过的内容,这就是“内插”。

大家可以通俗理解为,让大模型学习更多的新知识,以及不断巩固复习学过的旧知识。

我们还可以通过调整它的注意力机制,让它可以更轻松地找到信息之间的联系,就像是给这个超级大脑装了一个更聪明的搜索引擎。

通过这些技术的提升,我们的语言模型变得越来越强大,虽然还不是完美无缺,但已经能够处理很多复杂的问题了。

微软最近还发明了一种新的长文本解决方案,连反复训练和额外的硬件支持都不需要,就可以将上下文窗口拓展到200万Tokens的水平。

从学术的角度看,业界头部公司模型已经对长文本取得重大突破。

看全球,长文本护城河已经变浅

早在Kimi诞生之前,美国大模型界就已经赛过一轮长文本。

GPT4-Turbo已经支持128K Tokens,而Claude 2.1更是突破到200K Tokens。今年2月谷歌发布的Gemini 1.5直接一步到位推到了100万的水位,一口气能吞下一部《哈利波特》全集的长度,和1小时时长的电影。

全球第一梯队的三大模型,都实现了长文本突破。

Kimi走红后,今年3月份,国内的百度、阿里也加入了长文本战争,其他厂商的快速跟上,长文本的“护城河”已经不深了。

上下文窗口长度是越长越好吗?

理论上自然越长越好,但里边存在边际效应。

100万Tokens和200万Tokens以目前来看,可能没有本质区别。因为各路大厂们,现在他们都不继续卷了。

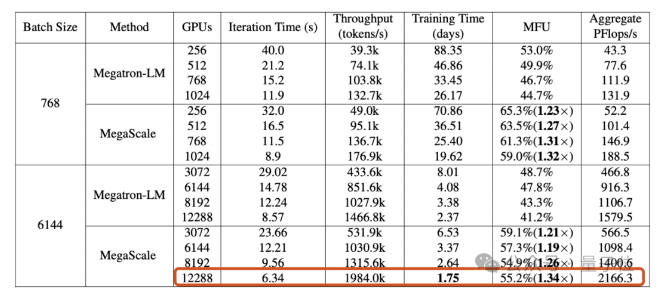

这是为什么?究其根本,是因为算力成本上不划算。

上下文越长,则需要计算的量级越大。根据实际测试反馈,Gemini在回答36万个上下文时需要约30秒,并且查询时间随着Token数量呈非线性上升,AI聊天机器人的应答时间也会显著变长。

AI大模型的计费方式是按Tokens计费,以输入的Token数量结算,大模型开发商需要自己承担这部分算力成本。

因此,我们会看到几乎所有的大模型都限制了用户的提问次数和提问Tokens长度。

诚然,未来随着算力和模型运行速度变得越来越快,成本和用户体感都会进一步上升。

但最近的研究表明,无限榨取大模型的上下文窗口Tokens,最终效果并不明显,推理能力明显出现衰退。所以,当前的方法下大模型可能能记住很长上下文,但懂多少,能用多少还是存疑的。

虽然“力大飞砖”,但不一定非得死磕这条路。

100万Token这个上下文长度,在主流的文本、代码为主的场景下,已经足够满足99%的使用场景。再卷,对用户而言毫无价值。

随着将来多模态大模型的发展,需要大模型Tokens更多的视频内容,各个模型供应商还是有再往上卷的理由。但在当下的算力成本之下,它的大规模应用应该还很难。

牛刀小试,终极目标还是AGI

最后,引出一个终极问题,靠“长文本”是否能形成大模型真正的护城河?

未来是最难判断的,关于长文本本身有多大可扩展空间。

Kimi创始人杨植麟的回答是:

非常大。

一方面是本身窗口的提升,有很长路要走,会有几个数量级。另一方面是,你不能只提升窗口,不能只看数字,今天是几百万还是多少亿的窗口没有意义。你要看它在这个窗口下能实现的推理能力、对原始信息的忠实度、遵循指令的能力——不应该只追求单一指标,而是结合指标的综合能力。

这波AI浪潮才刚刚开始,OpenAI CEO奥特曼也反复强调过,未来的大模型产品形态肯定是与今天完全不同的,就好像今天的手机与10年前大相径庭。

我们还没有办法清晰地看到它未来的样子,但是我们可以确定未来的“智能化”,将是AI技术重塑产品,如果一款产品只有20%-30%用到AI,那也不是一款人工智能产品。

未来的人工智能,它一定能理解你发出的超长指令,但是我们可能会忘记,AI技术一路发展走过来,曾经有一个技术指标叫做“长文本”。